El silicio empieza a recibir clases

Los expertos en inteligencia artificial llevan medio siglo tratando de que las máquinas emulen las habilidades cognitivas del ser humano

Los que se dedican a la inteligencia artificial considerarán que la pregunta de cómo se puede conseguir que una máquina aprenda es bella y profunda. Para el resto de mortales puede parecer tan absurda como preguntarse de qué manera aprende un zapato. Para conocer el mundo, hay que absorber información del entorno y tener la capacidad de clasificar en categorías ese amasijo de datos. El aprendizaje implica, además, la capacidad de distinguir unas características comunes entre distintos objetos que nos permitirán clasificarlos con criterios como el color o la forma. Es decir, aprender es la capacidad de adquirir una perspectiva, a la que uno se eleva por abstracción, desde la que entender mejor la realidad. Sin miedo a equivocarnos, a todo ser que manifieste estas habilidades podremos atribuirle inteligencia. Los humanos aprendemos; un zapato, no. Sencillo, ¿no? Pues no, porque los expertos en inteligencia artificial llevan medio siglo intentando que las placas de silicio —al fin y al cabo, arena de playa— emulen las habilidades cognitivas superiores del ser humano.

El reto es aún más complicado de lo que parece porque, para empezar, se sigue sin saber a ciencia cierta qué procesos neuronales participan en el aprendizaje y nos convierten en seres inteligentes. ¿Cómo se va a poder imitar la conducta cerebral si no sabemos ni cómo funciona? Esta paradoja ya dejaría fuera de juego a toda mente pusilánime y reflexiva, pero no ha detenido a los locos de la inteligencia artificial. Y tanta insistencia está a empezando a dar sus frutos: una nueva ola de programas que sacan el máximo rendimiento de los procesadores de última generación está obteniendo resultados que en algunos casos son espectaculares. Son programas que funcionan a partir de una rama de la inteligencia artificial bautizada como machine learning (aprendizaje automático) y deep learning (aprendizaje profundo, un término más específico que el anterior). Sus prometedores resultados están aflorando en un goteo de experimentos, concursos y, lo más interesante, aplicaciones con las que ya hemos empezado a interactuar.

Los vídeos de gatitos son a la inteligencia artificial casi lo que la perra Laika ha sido a la carrera espacial

Hasta hace pocos años un ordenador era incapaz de hacer nada con una imagen. Su papel era semejante al de un transportista que tiene que acarrear cajas de un lugar a otro o guardarlas en el almacén, sin que la curiosidad le lleve a fisgonear y ver lo que contienen. En 2012 un laboratorio de Google creó un algoritmo basado en el deep learning que inspeccionaba imágenes aleatorias de Youtube. Tras miles de visionados, el sistema fue capaz de distinguir los vídeos protagonizados por gatos del resto. Los algoritmos no contenían información previa sobre lo que tenía que encontrar, sino que llegó a este resultado tras un proceso lento de comparación y búsqueda de semejanzas. Por esta razón, se podría asegurar que los vídeos de gatitos son a la inteligencia artificial casi lo que la perra Laika ha sido a la carrera espacial.

De la sensación a la percepción

Existen programas capaces de analizar imágenes —procedentes de sensores o de bancos de internet—, compararlas y clasificarlas. Se trata de una habilidad que mimetiza lo que hace cualquier niño que ordene sus muñecos por estaturas o colores. Google, uno de los monstruos empresariales que está dedicando una gran cantidad de recursos a investigar sobre estos sistemas inteligentes, ofrece a sus clientes una aplicación que permite reconocer letras y textos dentro de fotos —como en carteles— y luego los traduce. Puede parecer un pequeño paso para un ser humano, pero es un gran paso para una máquina.

Un sistema parecido de reconocimiento de imágenes se está implantando en los automóviles automáticos. Por el momento, tales coches son meros prototipos, pero aspiran a conquistar las calles y convertir al conductor humano en una reliquia del pasado. Con los datos que recogen sus sensores, ahora mismo ya disponen de programas capaces de analizar las imágenes y reconocer los objetos que se interponen en su camino y así preparar la mejor respuesta que tenga que dar el coche. Todo ocurre en décimas de segundo y un error puede ser letal. En estos sistemas automáticos, la tolerancia al error es cero. Y por eso siguen necesitando perfeccionarse

En el análisis de sonidos también se han producido avances: los programas de reconocimiento de voz funcionan cada vez mejor y en la actualidad solo se equivocan en el 8% de los casos (hace dos años la cantidad de errores llegaba al 23%). Por eso Siri, el software de inteligencia artificial de Apple, o Cortana, el de Windows Phone, nos entienden mejor y cada vez resulta más difícil reírnos de su torpeza. Por otro lado, Skype ya ofrece un servicio de traducción automática de voz: dos personas pueden hablarse y entenderse usando lenguas totalmente diferentes. Entre medias, el machine learning está haciendo de las suyas para que esto sea posible.

Los psicólogos distinguen entre la sensación —el dato procedente de los sentidos— y la percepción, que es la habilidad del cerebro de reordenar e interpretar dicha información unificando los datos sensitivos para encontrar formas y, en definitiva, dar un sentido. Si los sensores son el equivalente a la sensación —gracias al machine learning y salvando todas las distancias— es como si a estas máquinas se las hubiera dotado de unas puertas de la percepción que se estarían abriendo.

Existe un programa que es capaz de concluir que “hay un gato encima de una silla” al inspeccionar una imagen de un gato sentado en una silla. De nuevo, parece otro logro exiguo de una lista muy larga, y más si se piensa que está al alcance de cualquier niño de tres años. Pero se trata más bien de una proeza, en la que unos algoritmos son capaces de interpretar el flujo de píxeles, encajar los datos en un concepto y, a partir de ahí, componer una frase.

Las computadoras están aprendiendo a manejarse con soltura en situaciones con factores imprevistos

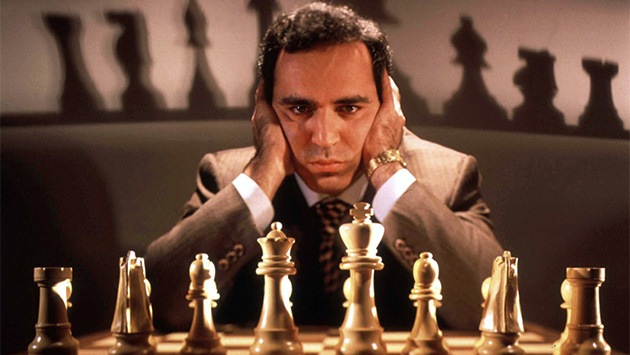

Las computadoras están también aprendiendo a manejarse con soltura en situaciones en las que intervienen factores imprevistos e incertidumbre. Su dominio es indiscutible en situaciones controladas como el juego del ajedrez desde que la computadora Deep Blue tumbó a Gari Kaspárov hace casi dos décadas. Pero también nos habíamos acostumbrado a que las máquinas fallaran cuando tenían que enfrentarse a los imprevistos del mundo real. Por eso tampoco extrañaba que genialidades de la ingeniería, como el pobre robot Asimov, sufrieran todo tipo de percances y acabaran de bruces contra el suelo cuando se las presentaba en público. Por no hablar de los primeros sistemas de reconocimiento de voz o de los sistemas de traducción automáticos, que parecían programados por poetas dadaístas. Con el machine learning, las máquinas están aprendiendo a ser menos torpes y manejar los imprevistos e incertidumbres tanto del mundo como del lenguaje. De momento, el entorno al que tiene acceso una computadora mediante este tipo de programas es limitado y los errores siguen siendo un cáncer que no se termina de extirpar. Pero estos primeros balbuceos ponen sobre aviso de lo que está por venir.

Todo son matemáticas

“El machine learning son unos programas que permiten que una máquina aprenda”, explica Ramon López de Mántaras en declaraciones a AHORA. “No se usan en robots fijados al suelo como los que se dedican a pintar coches, sino en robots que se mueven o que tienen que aprender algo del mundo que los rodea o tienen que coger cosas, por ejemplo, con unas pinzas. También se emplea en computadoras, cuando se quiere que distingan objetos en unas imágenes.” Director del Instituto de Investigación de Inteligencia Artificial del CSIC, Mántaras explica el funcionamiento de este tipo de programas de la siguiente manera: “Lo que buscan son patrones, repeticiones. Detectan similitudes de forma automática y sin supervisión”. Estos patrones pueden encontrarse en imágenes y también en sonidos: “Un sistema de deep learning podría distinguir partes de la señal sonora en función de cómo suena, basándose en fonemas”. Mántaras explica que a pesar de las mejoras sustanciales, “a la hora de clasificar imágenes se siguen equivocando más de la mitad de las veces. Estamos muy lejos de lo que logra hacer una persona”.

Mientras que machine learning es un término genérico con el que referirse a todos los programas cuyo fin es que las máquinas aprendan, el deep learning apunta a un tipo de estos sistemas, en concreto el basado en redes de neuronas. Tal como define este profesor e investigador en la Universitat Autònoma de Barcelona, “el deep learning no son más que operaciones matemáticas” con las que se logra algo parecido a la abstracción. Las funciones operan en primer lugar sobre los datos de entrada numéricos, a los que se aplican unas ecuaciones y se obtiene como resultado otro conjunto de números. “Las funciones están encadenadas, una detrás de otra, en cascada”, continúa Mántaras. “Los valores numéricos de salida de una función son la entrada a la siguiente función. Al conectarlas una detrás de otra sucesivamente pueden crearse varias capas.” Este proceso acaba conduciendo a la abstracción: “Cada capa hace un cálculo más complicado que la capa anterior, hace una operación un poco más abstracta”. En la capa final, el resultado es o 1 o 0.

Neurona o cerebro

Mántaras ejemplifica el funcionamiento de una red neuronal con un programa de reconocimiento de caras. En la primera capa, se introducirían los valores numéricos que corresponden a los píxeles de la imagen. La capa siguiente ya no recibe datos de píxeles, sino de líneas o de curvas. En la siguiente capa se distingue si hay una curva cerrada, como ocurriría si nos encontramos ante una cara. Cada nueva capa es un paso más en vertical, hacia arriba, hacia la abstracción. Al final, el sistema nos dirá o 1 o 0, es decir, si en la imagen hay una cara o no la hay. Las redes neuronales poco tienen que ver con la manera de funcionar del cerebro, a pesar de que la palabra neurona invite a compararlos. “Se llama neurona a lo que no es más que una función matemática”, explica. “En alguna ocasión se ha afirmado que las redes de neuronas se comportan de la misma manera que el cerebro humano, pero no es así. Para empezar, las redes neuronales necesitan cientos de miles de ejemplos para aprender un concepto como el de gato. Al niño le basta con un solo ejemplo para que pueda formárselo.”

Mántaras añade que el hecho de que la inteligencia humana no se parezca a la artificial tampoco tiene que verse como un problema. Simplemente son inteligencias diferentes: “Por muy potente y sofisticada que sea la inteligencia artificial, será distinta a la humana. Hará cosas impresionantes, pero será otra cosa”, afirma. Estos sistemas y programas van a dejar obsoletos muchos trabajos y van a transformar el mundo laboral de arriba abajo, pero la inteligencia humana no se verá eclipsada totalmente por la máquina: “La inteligencia artificial no va a dejar inútil u obsoleta la inteligencia humana”, sentencia Mántaras. “Además, pensar que en pocas décadas se superará la inteligencia humana no tiene ninguna base ni justificación real, científicamente no se aguanta.”

Las redes neuronales son viejas conocidas en el campo de la inteligencia artificial. Frank Rosenblatt, pionero de esta disciplina, fue uno de los primeros informáticos en diseñar una de estas redes en 1957. Su programa, instalado en una computadora IBM 704, se llamó Perceptrón y llegaba a reconocer algunas formas geométricas básicas. El impacto social de este logro fue impresionante, pero esta fama acabó teniendo un efecto negativo a medio plazo, cuando se constataron todas sus limitaciones. Pasaron décadas hasta que Geoffrey Hinton, desde la Universidad de Carnegie Mellon, mejoró notablemente los algoritmos de las redes neuronales, añadiera nuevas capas de neuronas y las convirtiera en lo que es deep learning. Su éxito también se ha labrado gracias a la presencia de procesadores potentes y el acceso a grandes bases de datos, sin los cuales estas redes no logran obtener los deseados resultados.

Alan Turing, el padre de la inteligencia artificial, ya pronosticaba en 1948 que las computadoras dominarían la lógica deductiva y aprenderían por inducción. Turing mostró al mundo que las capacidades cognitivas humanas no había que buscarlas en las profundas e insondables aguas del pozo del alma sino en simples mecanismos metálicos. Con el deep learning, el silicio logra manifestar chispazos de inteligencia. Es materia que se despereza de un sueño denso con ayuda de funciones matemáticas entrelazadas.